新智元报道

编辑:LRST

人类能通过视觉线索轻松完成购物找零等日常推理,但现有AI模型在类似任务中表现欠佳。浙江大学的研究团队将小学数学题转化为多图视觉基准,评估模型能否「看懂」数学,揭示其跨场景推理短板,为下一代通用智能模型发展提供方向。

「小明买了3个苹果,每个5元,他付了20元,应该找回多少钱?」

这是典型的小学数学应用题。但在日常生活中,我们更常遇到的是它的视觉版本:看到货架上的苹果标价牌,数出购物篮里的苹果数量,估算总价,再从收银员手中接过找零,快速判断对不对。

这个过程几乎不需要语言,而是依靠视觉线索完成推理:看到、比较、计算、验证。

语言让我们能以符号方式进行逻辑、推理与知识的传递,但人类真正的理解往往并不止于语言。

人类更擅长通过视觉去「看见」数量、空间与比例,以具象的方式形成抽象的逻辑。

正是在这一理念启发下,研究团队提出了一个关键问题:

「能否将自然语言表述的数学应用题转化为纯视觉形式的多图像问题,从而更真实地评估视觉语言模型(VLMs)的数学推理能力?」

视觉语言模型(VLMs)在图像与文本的联合建模上取得了显著进展,其在视觉问答、多模态理解等任务中表现优异。

但当把数学推理引入视觉场景时,现有模型仍面临明显瓶颈,且现有视觉数学基准存在以下局限:

当前视觉数学基准大多聚焦在几何题,任务范围过窄,无法覆盖实际应用题情形。

几乎没有对数学应用题的视觉化评估,因此无法衡量模型在真实数学理解任务中的能力。

很少涉及多图像跨场景推理,这使得难以检验模型跨场景关联能力。

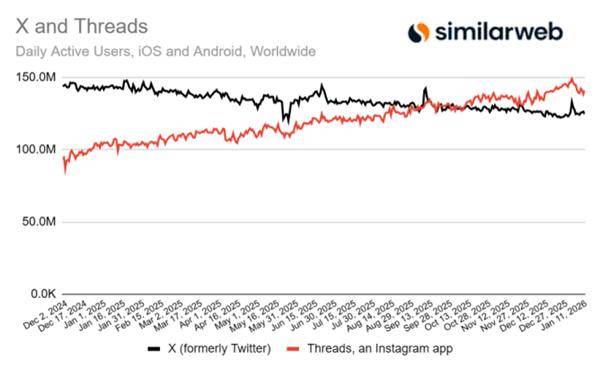

在文本数学基准GSM8K上,许多模型的准确率已轻松突破 90%,甚至达到或超越人类水平;

然而,当题目被转化为视觉形式后,研究团队发现:多数顶级模型瞬间腰斩,与人类水平存在显著差距。

面对这些问题,浙江大学的研究团队提出了GSM8K-V——将广泛使用的数学基准GSM8K系统性地映射为其视觉对应版本,构建出一个跨场景、多图像的视觉数学推理基准。该基准旨在检验模型是否真正能「看得懂」数学,而不仅仅是「读得懂」文字。

论文链接:https://arxiv.org/abs/2509.25160

项目地址:https://zju-real.github.io/GSM8K-V

代码仓库:https://github.com/ZJU-REAL/GSM8K-V

数据集:https://huggingface.co/datasets/ZJU-REAL/GSM8K-V

基准特点

基准的数据来源可靠:基于GSM8K测试集,共包含1,319道题目,对应5,343张高质量图像,平均每题4张图,最多可达11张。

任务覆盖全面:涵盖6大类、13个子类数学场景,从基础算术、测量、图形识别到时间与比例推理。

跨图推理能力测试:漫画式多场景视觉呈现,通过多场景组合检验模型在不同画面间的逻辑关联能力。

三阶段自动化构建流程

GSM8K-V的核心在于如何让「文字题」变成等价的「视觉题」。

为此,研究团队设计了一套三阶段自动化构建流程,确保视觉题与原始文本题目在语义上一一对应、逻辑一致。

阶段一:问题分解与场景分配

在这一阶段,使用GPT-4.1对GSM8K中的每道题进行数学信息分解,自动将题目拆解为结构化三元组(object, math value, semantic),精确标注出每个实体、对应的数值属性及其语义信息。随后,依据如下原则完成场景分配:

语境聚合(Contextual Grouping):同一类型或同一场景的数学信息被归入同一画面;

最终隔离(Final Isolation):题干的提问部分保留在最后一张图,确保推理目标清晰;

原子保真(Atomic Fidelity):严格避免推理性整合,仅保留最基础的数学事实。

此外,还在场景构建中引入多维干扰机制:通过在图像中加入感知干扰(如无关但显眼的物体)和语义干扰(与问题相关但误导性的元素),显著提高模型推理的真实性与挑战性。

阶段二:场景描述生成

为了让图像生成更精准,研究团队设计了基于元策略模板描述体系。针对不同类型的数学元素(如时间、百分比等),预定义专属提示词与视觉表达模板。

每个场景都由 GPT-4.1 生成结构化描述,采用三元组形式:(object:场景中必须出现的核心实体,action:描述对象的状态或动作,composition:定义所有元素在画面中的空间与层次关系)。

这种结构化描述确保了不同场景之间的一致性,为后续图像生成提供了可复现的视觉蓝图。

阶段三:图像生成与交叉验证

在该阶段,团队使用GPT-Image-1模型生成多场景漫画式图像,每张分辨率达1024×1024。所有图像均经过双重人工交叉验证,确保其准确性与合规性,遵循三条准则:

一致性(Consistency):图像中的实体、数量、约束需完全保留原题语义;

完整性(Completeness):解题所需的全部信息都应在画面中可见;

合规性(Compliance):图像内容需安全、清晰,无模糊或误导元素。

对存在偏差的样本,人工标注者会重新校正场景描述或图像内容,以保证数据集质量与学术可复现性。

实验结果

研究团队在GSM8K-V上系统评测了19个主流视觉语言模型,包括闭源模型Gemini-2.5-Pro、GPT-5,以及开源代表Llama-4、InternVL3.5、Qwen2.5-VL等,全面分析了它们在视觉数学推理任务中的表现。结果揭示了视觉推理任务的巨大挑战性以及人机间显著的差距。

文本推理几近饱和

在传统的GSM8K 文本基准上,即便是表现最差的模型也能取得78.32%的准确率,而绝大多数模型(14/19)已经轻松突破90%,说明大模型在纯文本数学推理任务上已经接近饱和,甚至达到或超过人类水平。

视觉推理仍是「硬骨头」

当任务从文字转化为视觉场景后,模型的表现却出现了显著下降。在GSM8K-V 上,最强闭源模型Gemini-2.5-Pro仅取得46.93%的准确率,而包括GPT-5、Llama-4-17B-128E在内的模型也仅维持在30%左右。

这表明,VLMs 在面对真实世界的多图像数学推理时依然存在显著短板,尤其是在跨场景关联、多图理解以及数值逻辑一致性方面。

GSM8K-V因此成为一个极具挑战性且具有可持续研究价值的视觉数学推理基准,为未来模型能力提升提供了新的方向。

人机差异:不仅是准确率,更是理解方式

人类在GSM8K-V上的平均准确率高达91.15%,且在所有类别中都保持稳定(86.76%–96.05%)。

相比之下,模型不仅整体准确率偏低,还表现出显著的不均衡性。例如:GPT-5在「 Signboard & Icon 」和「Measurement」类别上表现相对较好(约 41–46%),但在「Other」类别上急剧下滑,仅24.93%。

开源模型Step3在「Physical Metric」和「Temporal」任务中表现尚可,但在其他类型中明显不足于同级模型。

更重要的是,人类与模型在擅长的类别上几乎完全不重合。人类在「Other」类别上的准确率高达 93.25%,甚至超过其在「Signboard & Icon(90.27%)」和「Measurement(86.76%)」上的表现;

而模型恰恰相反,往往依赖视觉符号或数值表征,难以捕捉更抽象的语义逻辑。

这表明,人类的视觉推理更加平衡和可泛化,能够灵活地从图像中建立语义联系;

而现有 VLMs 仍倾向于依赖类别特征或模式匹配,缺乏深层的语义理解与抽象推理能力。

分析与发现

为进一步分析GSM8K-V的稳健性与挑战性,研究团队从输入格式、视觉风格、模态依赖以及错误类型等方面进行了系统消融实验与分析。

结果揭示了视觉数学推理任务中的关键影响因素与典型模型误差模式。

单图与多图输入

在多图输入场景下,模型平均准确率略高于单图拼接输入。研究表明,将问题分解为多张顺序图像有助于模型保持事件的逻辑与时间顺序,从而更接近人类推理过程。

相反,将所有场景拼接为单张图片往往导致语义依存关系被破坏,使模型难以捕捉跨场景的关键推理线索。

单图与多图输入结果

单图与多图输入示例

视觉风格敏感性

GSM8K-V默认采用Pixar风格的视觉渲染,以保证图像清晰、光影自然、语义明确。为检验模型对图像风格的敏感性,研究团队在子集上重绘了Giphli风格版本。

结果显示,不同风格下的模型性能差异极小(通常低于2%),说明GSM8K-V的结果具有较高稳健性,视觉风格变化不会显著影响数学推理表现。

视觉风格结果

视觉风格示例

模态验证实验

为了验证GSM8K-V的任务确实依赖视觉推理而非文本转写,研究团队比较了四种输入模式:文本输入(text-only)、图像输入(image-only)、OCR转写输入以及场景描述输入(caption-based)。

结果表明,OCR模式下性能极低(10%左右),说明模型无法仅通过图像转写的文字获得有效信息,视觉理解在任务中不可或缺。

相比之下,结构化场景描述(caption)模式的表现显著优于纯图像输入,但仍远低于文本任务准确率,表明视觉信息中存在大量隐含语义和空间关系,仍难以通过语言重构完整还原。

模态验证结果

问题表述形式

当问题陈述以文字形式直接嵌入输入中(explicit 模式),模型的准确率略有提升。这说明文本化的提示有助于消除视觉语义指代的歧义。

然而,即使在这种「显式」支持下,模型的准确率依然远低于文本任务(例如 Gemini-2.5-Pro:47.6% vs. 95.2%),表明多模态推理尚未实现真正的语义整合。

Explicit输入示例

Implicit输入示例

Explicit与Implicit结果对比

错误类型分析

在模型错误分布中,研究团队总结出两类典型失误:

感知—计算错误(Perception–Calculation Errors)

模型在面对多个相似物体或细粒度数量区分时,常发生识别错误或类别混淆,进而导致后续计算结果偏差。

例如,模型可能误判物体数量、混淆计价单位,从而直接导致推理崩溃。这类错误暴露出模型在「视觉计数」与「数值绑定」之间的薄弱环节。

仪表读取错误(Instrument-Reading Errors)

当数值信息通过日常工具(如钟表、仪表盘、刻度尺等)呈现时,模型常出现误读或误映射。例如,无法正确读取钟表时间、混淆百分比图表的比例或误判量表刻度。

这类错误揭示了模型在「视觉数感」方面的显著不足。

整体来看,GSM8K-V 揭示了当前视觉语言模型的真实瓶颈:文本推理已趋近饱和,但视觉推理仍是尚未攻克的关键挑战。

这一结果不仅凸显了视觉数学推理任务的研究价值,也为下一代通用智能模型的发展指明了方向:真正的智能,不止能「读懂文字」,还应「看得懂世界」。

作者介绍

论文的共同第一作者是袁凡和颜聿辰。袁凡是浙江大学硕士研究生,主要研究兴趣集中在大模型推理和多模态大模型;颜聿辰是浙江大学博士四年级研究生,主要研究兴趣集中在大模型推理和智能体。本文通讯作者是浙江大学百人计划研究员沈永亮。

参考资料:

https://arxiv.org/abs/2509.25160

京公网安备 11011402013531号

京公网安备 11011402013531号