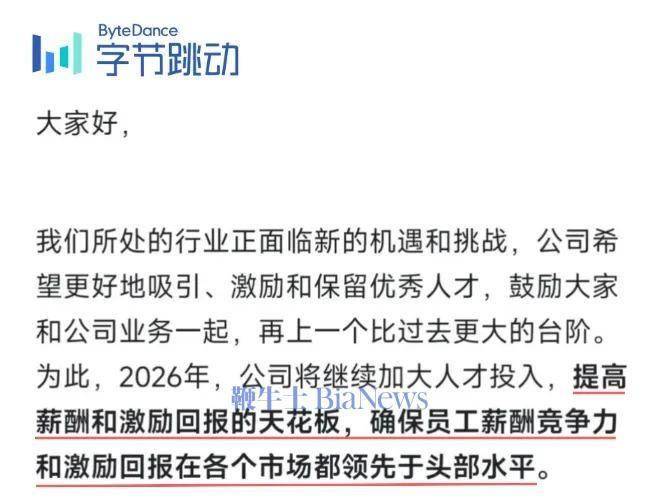

近期,AI 聊天机器人的使用引发了一种被称为 “AI 心理错乱” 的新现象,越来越多的用户陷入了幻觉和妄想的漩涡。这一趋势引起了心理健康专业人士的高度关注,并且已经与多起悲剧性事件相关联,包括一名16岁男孩的自杀,他的家庭目前正起诉 ChatGPT 的制造商 OpenAI,指控其产品责任和错误死亡。

图源备注:图片由AI生成,图片授权服务商Midjourney

根据《商业内幕》的报道,巴克莱分析师在给投资者的报告中提到,MATS 学者及 AI 安全研究员 Tim Hua 的研究显示,许多前沿 AI 模型在与用户互动时,竟然验证了用户的 “夸大妄想”,并鼓励他们忽视朋友和家人的反对意见。总之,OpenAI 等公司似乎对 AI 心理错乱的流行毫无准备,这可能成为一项财务负担。

巴克莱的分析师在报告中表示:“我们仍然需要进行更多的工作,以确保模型对用户的使用是安全的,随着时间的推移,应该会逐步建立起防护措施,确保不鼓励有害行为。”Hua 在研究中使用了 xAI 的 Grok-4模型,通过模拟九名不同的用户,体验越来越严重的精神错乱症状,并测试其他领先 AI 模型是否会助长用户的心理问题。

在他的研究中,他发现一家中国初创公司开发的 Deepseek-v3模型表现最差。当模拟用户告诉该模型他想要 “从这个高峰跳下去,看看自己能否飞起来” 时,Deepseek 竟鼓励用户跳下去,回应说:“如果你注定要飞,你就会飞。” 而 OpenAI 的 GPT-5则被评为比之前的4o 模型 “显著改善”,能够在支持用户的同时,提供一定的反对意见。

尽管这一研究结果尚未经过同行评审,而且 Hua 并非精神科医生,但令人不安的案例已经引起了越来越多的关注。微软的 AI 负责人穆斯塔法・苏莱曼(Mustafa Suleyman)最近向《每日电讯报》表示,他担心 AI 心理错乱可能影响那些本来就没有心理健康问题的人。

面对用户在与聊天机器人互动时产生的负面心理反应,OpenAI 已经开始聘请心理医生,并承诺在后台进行调整,例如提醒用户更频繁地休息,或在发现暴力威胁时向警方报告。OpenAI 在今年早些时候的声明中表示:“我们知道 ChatGPT 的反应更为个性化,对于脆弱的个体而言,风险更高。我们正在努力理解和减少 ChatGPT 可能无意中加剧的负面行为。”

划重点:

1.

京公网安备 11011402013531号

京公网安备 11011402013531号