开源人工智能(AI)的价值正获得更广泛的认可。

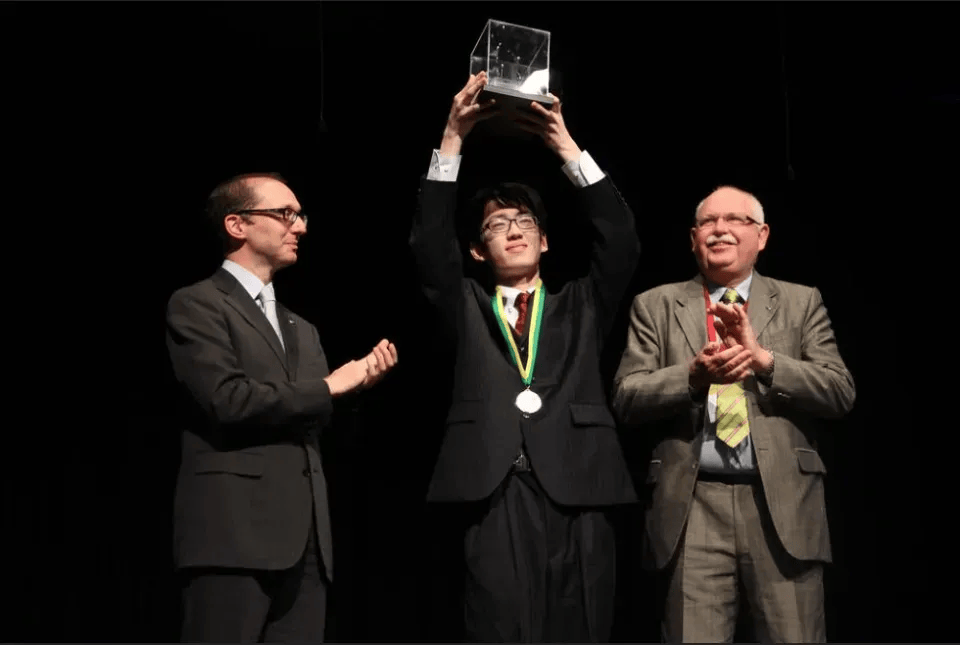

刚刚,DeepSeek-R1 论文以封面文章的形式登上了权威科学期刊Nature,DeepSeek 创始人兼 CEO 梁文峰为该论文的通讯作者。

论文链接:

https://www.nature.com/articles/s41586-025-09422-z

研究团队假设,人类定义的推理模式可能会限制模型的探索,而无限制的强化学习(RL)训练可以更好地激励大语言模型(LLM)中新推理能力的涌现。

他们通过实验证明,LLM 的推理能力可以通过纯 RL 来提升,从而减少增强性能所需的人类输入工作量,且在数学、编程竞赛和 STEM 领域研究生水平问题等任务上,比经传统方法训练的 LLM 表现更好。

DeepSeek-R1 推出后,得到了全球开发者的广泛好评,截至发文前,其在 GitHub 上的 star 数已经达到了 91.1k。

在一篇同期发表的观点与评论文章中,卡内基梅隆大学助理教授Daphne Ippolito和他的博士生张益铭(现为 Anthropic 的 LLM 安全和对齐研究员)评价道:

“DeepSeek-R1 已从一个强大但不透明的解决方案寻找者,发展成一个能够进行类人对话的系统。这一历程反映了(人类)对 AI 系统的需求,这些系统不仅要准确地解决问题,还要成为人类可以理解、信任并能进行有意义协作的工具。”

文章链接:

https://www.nature.com/articles/d41586-025-02703-7

此外,

Nature也在 Editorial 文章中肯定了这项工作,“DeepSeek-R1 是第一个在经过同行评审后发表的主流 LLM,这是朝着透明化迈出的可喜一步”。

文章链接:

https://www.nature.com/articles/d41586-025-02979-9

他们一针见血地指出,经同行评审的论文发表有助于澄清 LLM 的工作原理,并帮助评估它们是否“货真价实”(whether they do what they purport to do)。

DeepSeek-R1 背后的科学

人类定义的推理模式可能会限制模型的探索,而无限制的 RL 训练可以更好地激励 LLM 中新推理能力的涌现。

让机器像人类一样进行通用推理,一直是 AI 领域的核心难题。

尽管思维链(CoT)等方法能够有效提升 LLM 的推理表现,但严重依赖人工标注,不仅扩展性差,还可能因人类的认知偏差而限制模型自身的潜能,使其无法探索更优的、非人类的推理路径。

DeepSeek-R1 的重要意义在于,它证明了通过纯粹的 RL 即可激发 LLM 的推理能力,而无需依赖人工标注的推理过程(数据)。

不同于基于提示的方法和监督学习等早期方法,研究团队提出了一种新范式——在 RL 框架中,以最小化对人工标注的依赖,探索 LLM 通过自我演化来发展推理能力的潜力。

基于提示的方法 vs. 监督学习 vs. RL 正如 Ippolito 等人所比喻的,RL 算法的工作方式类似于人类玩家学习玩电子游戏的过程:玩家在游戏世界中操作角色,通过不断试错发现哪些行为会带来奖励——例如“收集金币”可以增加分数,而“撞到敌人”则会让分数归零。 相比之下,基于提示的方法更像是让他们通过阅读说明书来学会玩游戏,而监督学习则像让他们观察其他玩家玩游戏数百次,试图通过模仿掌握游戏技巧。

他们发现,当 LLM 通过 RL 的试错过程被训练以产生正确答案时,它会自然而然地学会输出其推理过程。

考虑到数学和编程问题通常有可验证的答案,他们通过创建一个评分系统来帮助 DeepSeek-R1 在训练过程中进行改进——回答正确得高分,反之得低分。

在具体实现上,他们提出了一个名为“群体相对策略优化”(GRPO)的 RL 算法,并基于基础模型 DeepSeek-V3 base 训练了 DeepSeek-R1-Zero、DeepSeek-R1 等模型。

图|RL 框架

从 DeepSeek-V3 base 开始,通过涉及拒绝采样、RL和监督微调(SFT)的多阶段 pipeline,研究团队先后训练了 DeepSeek-R1-Zero、DeepSeek-R1 Dev1、DeepSeek-R1 Dev2、DeepSeek-R1 Dev3 和最终的 DeepSeek-R1。

图|DeepSeek-R1 的多阶段 pipeline

据论文描述,DeepSeek-R1-Zero自然演化出了多样且复杂的推理行为。在解决推理问题时,模型倾向于生成更长的响应,其中包含验证、反思和替代方案的探索。这表明,模型通过 RL 能够成功地学会更优的推理策略。

然而,DeepSeek-R1-Zero依然存在一些局限,比如“输出可读性差”和“语言混用”等。而且,由于其基于规则的 RL 训练阶段仅聚焦于推理任务,在写作和开放域问答等更广泛场景中的表现较差。

为此,研究团队通过随后的多个训练阶段进一步强化了 DeepSeek-R1 系列模型的综合能力。具体而言:

DeepSeek-R1 Dev1:相较于 DeepSeek-R1-Zero,指令遵循能力提升;

DeepSeek-R1 Dev2:在代码、数学和 STEM 等领域,高级推理能力进一步增强;

DeepSeek-R1 Dev3:引入大规模非推理语料和代码工程数据,推理与通用语言生成能力得到提升;

DeepSeek-R1:推理能力强,且行为与人类偏好对齐。

最后,他们在 MMLU、MMLU-Pro、C-eval、GPQA Diamond、SimpleQA、SWE-bench Verified、LiveCodeBench 和 AIME 2024 等 21 个主流 benchmark 上分别对 DeepSeek-R1 等模型进行了评估。

如下表,DeepSeek-R1 几乎在所有 benchmark 上均取得了更好的成绩。这些结果验证了这一 RL 框架的有效性。

图|DeepSeek-R1 每个训练阶段的评测结果

此外,研究团队还表示,这一 RL 框架有助于形成一些高级的、涌现的推理模式,如自我反思、验证和动态策略适应。而且,这些涌现出的推理模式还可以被系统地用于指导和增强小型模型的推理能力。

启示:亟需遏制 AI 行业的过度炒作

考虑到这项技术已无处不在,未经证实的言论对社会而言是切实的风险。

除了 DeepSeek-R1 的在科学层面的研究意义,

Nature在 Editorial 文章中着重探讨 了一个业内讨论不够多的问题 :

绝大多数被广泛使用并正在迅速颠覆人类获取知识方式的 LLM,都尚未经过独立同行评审,这是一个值得注意的「缺失」。

他们称,DeepSeek-R1 论文的发表“是朝着透明化迈出的可喜一步。”

据介绍,DeepSeek-R1 的原创性、方法论和鲁棒性,已接受八位人类专家的评审。论文将与评审报告及作者回复一同发表。“在一个常常充斥未经验证主张和炒作的行业中,这无疑是迈向透明性与可重复性的重要一步。”

Nature方面认为,与在预印本 arXiv 发表论文不同,参与同行评审的外部专家不再是单向接收信息,而是在一个由独立第三方监督和管理的协作过程中提问并请求更多信息。“虽然这不总能带来重大改变,但可以增加研究的信任度。对于 AI 开发者而言,这意味着他们的工作得到了‘权威背书’,从而在不同社区中更具公信力。”

同时,同行评审还起到了制衡作用,避免 AI 开发者通过挑选最有利于自己模型的基准测试而“自我打分”。这是因为,基准测试是可以被操控的。例如,如果训练数据中包含测试题目和答案,模型就可能提前学会正确回答,从而导致其能力被高估。

此外,同行评审还可以促成论文的其他重要修改,其中之一是确保作者对模型的安全性有所回应。AI 的安全性意味着要避免意料之外的有害后果,包括缓解输出中的固有偏见,以及增加防护措施以避免 AI 被用于网络攻击。

一些人认为开源模型比专有模型更不安全,因为一旦用户下载,它们就脱离了开发者的控制。不过,开源模型也让更广泛的社区能够理解并修复缺陷。

例如,DeepSeek-R1 的审稿人指出,论文缺少关于安全性测试的信息——并未评估基于 R1 构建一个不安全模型的难易程度。作为回应,研究团队在论文中添加了重要细节,包括一个专门的章节,介绍了他们如何评估模型的安全性并将其与竞争模型进行比较。

鉴于 DeepSeek-R1 是一个开放权重模型,任何研究人员和公众都可以不受限制地自由下载、使用、测试和在其基础上进行开发,因此其安全问题不容忽视。

在 Editorial 文章的最后,

Nature呼吁道,希望更多的 AI 公司将其模型提交给出版物评审。“评审并不意味着让外界接触公司的秘密,而是要准备好用证据支持你的言论,并确保相关主张得到验证和澄清。”

如今,伴随着国内外 AI 行业的白热化竞争,一些模型厂商在投入巨大资金的同时,忽视了数据偏见、模型安全等问题,甚至存在主动刷榜、夸大模型能力的行为,“对社会而言是切实的风险”(a real risk for society)。

或许正如

Nature所言,依赖独立研究者的同行评审,是缓解 AI 行业炒作的一种方式。

对此,你怎么看?

作者:学术君

如需转载或投稿,请直接在公众号内留言

京公网安备 11011402013531号

京公网安备 11011402013531号