报道

编辑:KingHZ 英智

2025年,ChatGPT依旧领跑,但DeepSeek、Qwen等开源劲敌正加速追赶。从「推理革命」爆发到 DeepSeek开源,一场围绕算力、架构与生态的战争已悄然打响,开源势力正以星星之火之势挑战闭源巨头。

2025年,AI江湖风云再起!

第一季度过去了,OpenAI仍然处于全球领先地位。

但其他公司正在迅速追赶,尤其是国内开源AI模型紧追不舍,且接近顶尖水平。

独立机构Artificial Analysis,发布了2025年第一季度AI报告,总结了六大趋势,涵盖技术突破与市场格局演变。

报告亮点如下:

过去两年中,GPT-4级别推理成本下降了1000倍。

三大驱动力引发AI成本革命:更小的模型、推理优化和新一代硬件。

目前,智商天花板全是推理模型,但非推理模型还是性价比之王。

现在的AI能自主浏览代码库、创建文件、写代码、跑测试,不止补全代码。

多模态和智能体让AI从「单一工具」变成「全能助手」,离日常生活越来越近。

根据Artificial Analysis的官方分析,2025年初的AI有六大定义性结论:

1.前沿AI竞赛持续升温:顶级实验室正以每8-12周的速度推出新模型。

OpenAI仍处于领先地位;在其身后,不仅有谷歌和Anthropic等传统挑战者,xAI、DeepSeek和阿里也已加入,形成了紧密的追赶梯队。

2.推理模型投入实际应用:那些「先思考后回答」的模型,牺牲了一定的速度和成本,换取了更高的智能水平,使用的token数量和成本是非推理模型的10倍左右。

3.MoE模型已无处不在:混合专家模型(MoE)在为每个生成的token进行计算时,仅激活其总参数不到10%。目前,大多数顶级的开源权重模型均采用了MoE架构。

4.中国顶级实验室差距显著缩小:DeepSeek等中国公司正纷纷推出极具竞争力的模型,并常常选择公开模型权重。

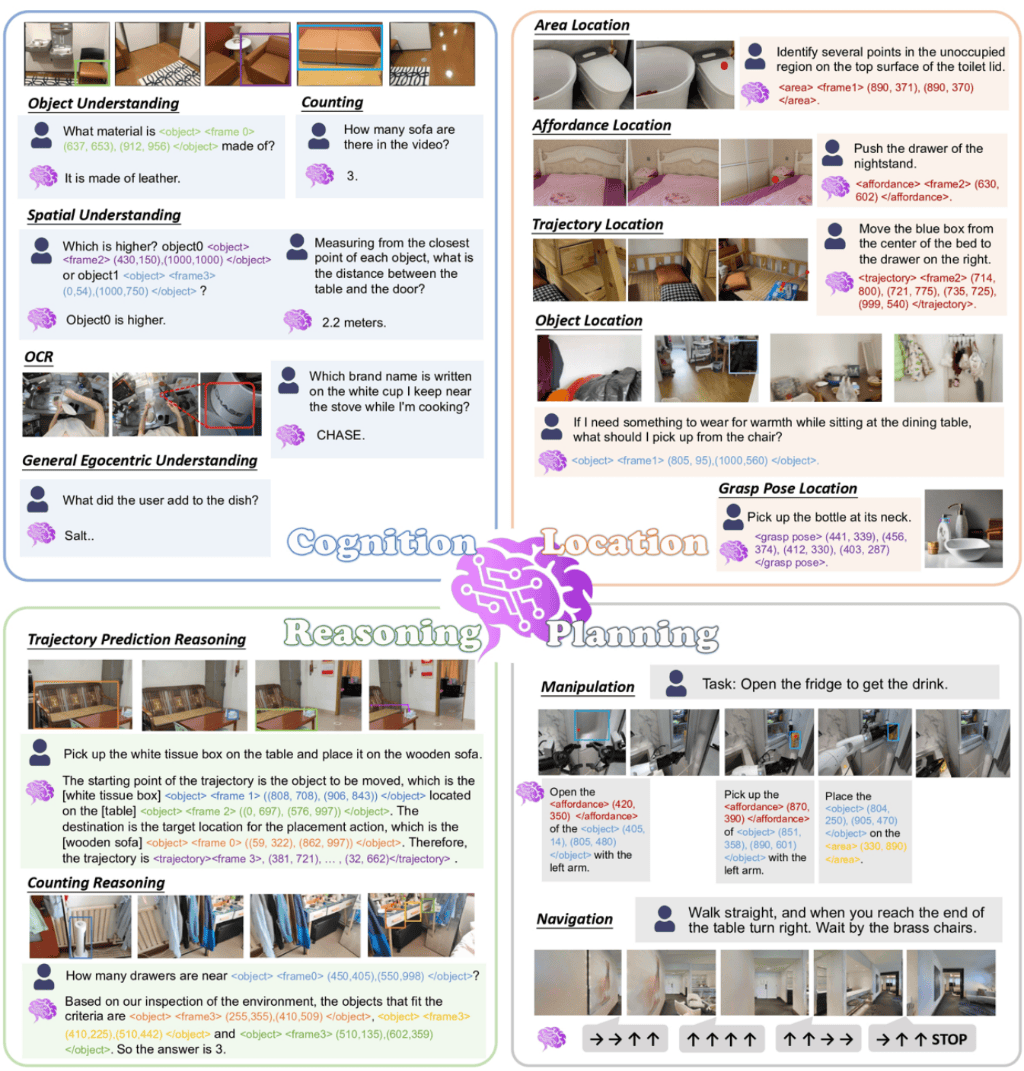

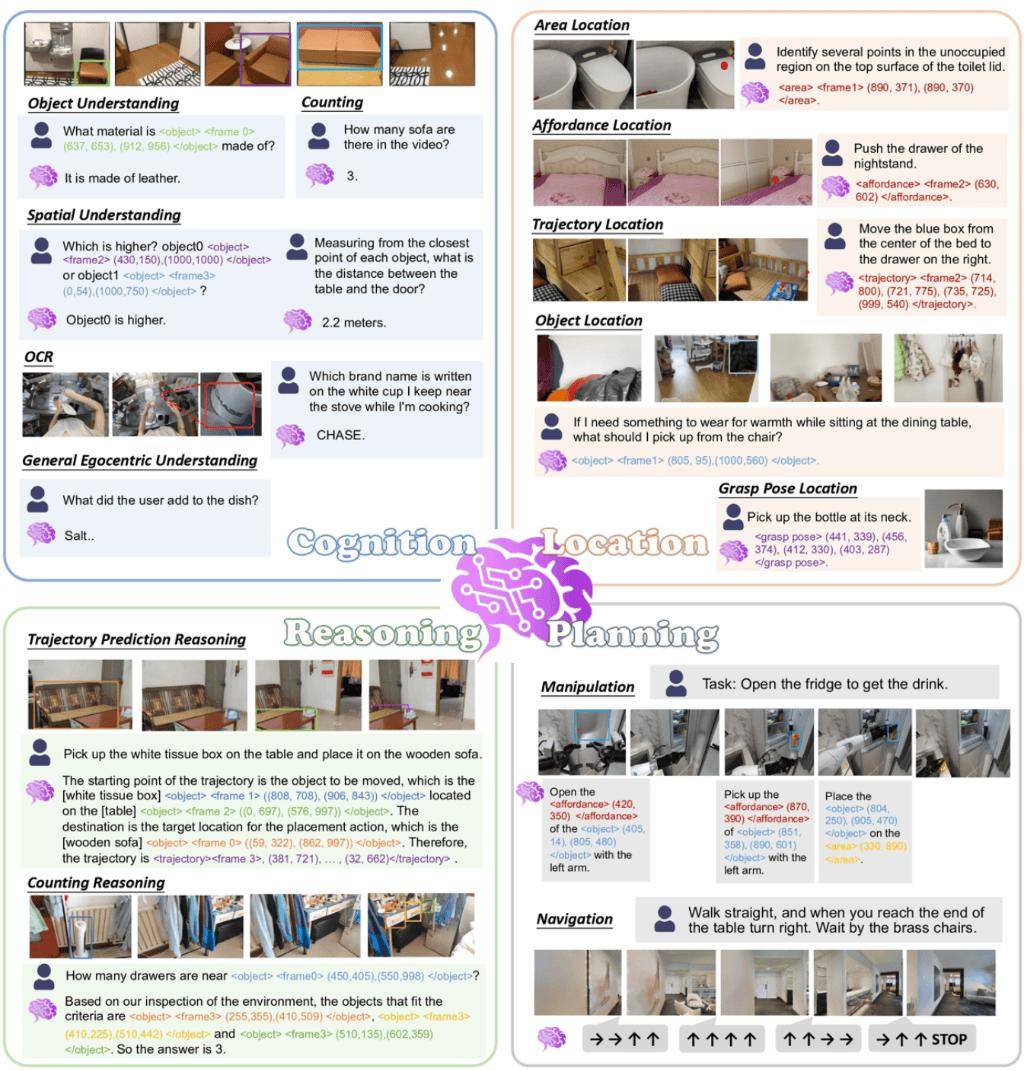

5.AI智能体走向实用化:由LLM驱动、能自主行动并使用工具端到端完成任务的系统,正开始在实际工作中显现成效。新兴的AI智能体类别包括编程智能体、深度研究智能体(Deep Research Agent)以及计算机辅助使用智能体。

6.大语言模型原生支持多模态:大语言模型如今的输出已远不止于文本。GPT-4o目前在图像生成方面独占鳌头,同时各类语音到语音(Speech to Speech)模型也已相继问世。

AI大洗牌

推理模型称王

2024年末,OpenAI利用大规模强化学习训练的推理模型o1,将性能差距彻底拉开,颠覆了全球AI格局。

OpenAI全球领先,但竞争对手紧追不舍

如今,Llama Nemotron Ultra、Qwen3等开源模型,已成燎原之势。

私有模型和开源模型的差距变化

推理模型能够逐步拆解任务、自我校验,尤其在复杂问题如数学推理、研究辅助中表现出明显优势。

比如,Gemini 2.5 Pro遇到问题会先拆解步骤、自我纠错,像解数学题一样一步步来,虽然花21秒,输出1967个token,但答案准;而非推理模型(如GPT-4o)4秒输出185个token,结果答错了。

可以看到,在目前的Artificial Analysis智能指数中,最聪明的全是推理模型。

其中,o4-mini(high)排名第一,谷歌Gemini 2.5 Pro和Grok 3紧随其后。

开源模型(如DeepSeek R1、Qwen 3、Llama 3.1)性能虽然落后闭源模型,但两者非常接近。

「高情商」的推理模型,背后是高成本:要达到相同的性能,推理模型要使用非推理模型10倍以上的输出token!

尽管在效率方面取得了显著进展,推理速度比过去更快,但推理模型和智能体应用每次请求生成的token是过去一年平均水平的10多倍。

综合下来,用户反而要等待更长的时间。

LLM输出速度变化

非推理模型也没被淘汰,需要快速响应或省钱的场景,还是性价比之王。

开发者不能仅看单token定价,还需综合考虑token总使用量,才能准确评估推理成本。

实际上,如今的顶级AI模型参数规模更大,每次请求需要的token数总更多,现在的AI应用需要更多的算力。

因此,最新的模型开始探索如何在智能和成本之间取得平衡。

其中,最引人注目的进展来自架构上的权衡优化。

Epoch AI对每种算法进步的计算等效增益的估计

混合专家

省钱又提速

DeepSeek-V3的混合专家(MoE)架构,如今已无处不在。

DeepSeek-V3基本架构

传统模型像全科医生,不管啥问题都调动全部知识;MoE像专科门诊,遇到不同问题找对应的专家(激活部分参数)。

如果说全连接模型是「广撒网捕鱼」,MoE则是「精准出击」,不仅能减少参数激活量,还大幅提升推理效率。

近期开源的前沿模型越来越多地使用MoE架构,每次输入仅激活部分参数。

前沿模型采用更稀疏的MoE设计,仅激活不到10%总参数,早期模型通常激活约25%的参数。

在推理和训练上,参数规模相同的MoE模型比稠密模型更高效。

此外,英伟达是算力领导者,Cerebras、SambaNova、Groq这些新玩家将「芯片+云服务」打包卖,通过垂直整合提供高性能推理,输出速度更快。

但开发者需要在性能、成本和上下文窗口之间权衡。

虽然服务速度更快,但这些芯片新玩家有时比其他服务商价格更贵,且上下文窗口更短。

智能体

自主干活的「虚拟员工」

智能体是2025年AI领域的重要趋势。

凭借LLM的推理能力,通过高效的工具使用和自主流程管理,大幅提升了任务完成的效率和智能化水平。

它们能自主完成复杂任务,尤其是编程、深度研究、操作计算机和客户支持。

从自动补全(2021年)到现在能自主浏览代码库、创建文件,比如让它搭个OAuth认证系统,它能自己写代码、跑测试,还能告诉你改了哪些文件。

比如问「AI对就业的影响」,它会自己拆分问题、查资料、整合答案。还能批量处理表格,打工人看了想流泪。

原生多模态

图像、视频、语音全面升级

OpenAI的GPT-4o画出的图又逼真又贴合需求。

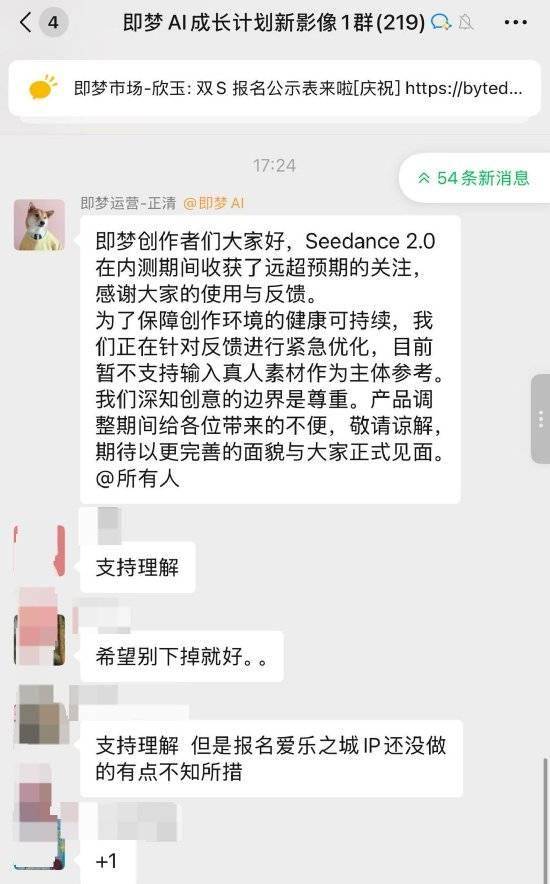

字节跳动的Seedream 3.0、MiniMax的HiDream-I1-Dev一发布就冲进第一梯队。

以前OpenAI的Sora是视频界扛把子,现在谷歌Veo 3超越了它,MiniMax和快手也推出了能追上Sora的模型。

ElevenLabs的Scribe模型把语音转文字的错误率降到8%,比OpenAI的Whisper还准;文本转语音也更像真人了。

大型科技公司持续在所有领域全面发展,而较小的竞争者通常专注于特定的AI领域。

谷歌是AI价值链中垂直整合度最高的企业(从TPU加速器到Gemini模型);NVIDIA、微软、亚马逊等在硬件、云推理和应用层各有侧重。

未来AI会怎么发展?大概率会更全能、更聪明,也更接地气。

说不定下次开会,你的会议纪要就是AI智能体帮忙写的。

开源

大势所趋

随着越来越多的企业在业务中构建和部署AI驱动型解决方案,日益丰富的开源技术正成为首选,包括meta的Llama系列、谷歌Gemma系列、艾伦人工智能研究所Ai2的OLMo系列、英伟达的NeMo系列、DeepSeek-R1等众多选择。

Mozilla基金会等机构联合开展了一项开创性调研,覆盖41个国家700多位技术负责人和资深开发者。

调研结果显示,企业在AI工具选择上日益偏向开源方案:

总体而言,超过四分之三的受访者预计他们的组织将在未来几年内增加对开源人工智能技术的使用。

这在一定程度上得益于开源工具在企业软件生态中的活跃表现,且长期以来始终是开发者社区的基础资源。

在Sequoia合伙人Lauren Reeder主持的一场圆桌讨论,揭示了关于开源AI模型当前状况和未来趋势的诸多关键见解。

目前在OpenRouter平台上运行的推理任务中,只有大约20%-30%使用的是开源模型。尽管如此,与会者对未来的增长充满信心。

本月OpenRouter的token使用总量排行榜

当被问及五年后开源与闭源模型在推理任务中的占比预估时,Jeffrey和Dmytro认为开源AI将和闭源AI分庭抗礼。

Jeffrey预测开源与闭源将各占一半,但也提到可以在开源与闭源模型之间智能切换的技术。

Dmytro也倾向于50/50的预测,但他指出开源生态将更加多样化:「闭源可能仍由少数几家主导……而开源则不会只有一个模型,会是更多的模型家族、微调版本和定制化方案。」

独立机构Artificial Analysis最近的报告,也印证类似的AI发展趋势。

Artificial Analysis认为虽然闭源推理模型整体上领先,但开源模型和闭源模型与2022年相比,差距已经变小。

而在非推理模型方面,开源模型反而比闭源的商用模型更具优势。

特别是国产开源AI模型,已经成为一股不容忽视的力量。

参考资料:

京公网安备 11011402013531号

京公网安备 11011402013531号